Лекция 8-9

Тема: Управление и хранение данных. СХД. Часть II

Интерфейс iSCSI

Обычно представлен внешним разъёмом RJ-45 для подключения в сеть Ethernet – всем нам известный разъём:

…и собственно самим протоколом iSCSI (Internet Small Computer System Interface). По определению SNIA: «iSCSI — это протокол, который базируется на TCP/IP и разработан для установления взаимодействия и управления системами хранения данных, серверами и клиентами». На этом интерфейсе остановимся немножко подробней, хотя бы в силу того, что каждый пользователь способен использовать iSCSI даже в обычной «домашней» сети.

Необходимо знать, что протокол iSCSI определяет, как минимум, транспортный протокол для SCSI, который работает поверх TCP, и технологию инкапсуляции SCSI-команд в сеть на базе IP. Проще говоря, iSCSI – это протокол, позволяющий получить блочный доступ к данным с помощью команд SCSI, пересылаемых через сеть со стеком TCP/IP. iSCSI появился как замена FibreChannel и в современных СХД имеет перед ним несколько преимуществ – способность объединять устройства на огромных расстояниях (используя существующие сети IP), возможность обеспечивать заданный уровень QoS (Quality of Service, качество обслуживания), более низкую стоимость connectivity.

Адресация iSCSI-устройств многим покажется слишком сложной, но это итог формирования стандартов эпохи расцвета IT. Существуют два типа адресации – EUI-based и IQN, про-сто приведу примеры записи адресов двумя различными методами адресации (они не эквивалентны друг другу – это лишь пример):

• eui.5a1b375297690100;

• iqn.1979-07.ivs.home:winxp.

Однако возможность организовать SAN на базе iSCSI проще, чем вам кажется. Что необходимо для сети данных? Устройства хранения, компоненты коммутации (connectivity) и хосты. Хостами могут быть обычные компьютеры, компоненты коммутации – это ваша локальная IP-сеть, сложнее с системой хранения, но и это решаемо. В терминологии iSCSI принято различать два типа устройств – Initiator и Target. Как вы уже догадались: Initiator – это хост, а Target – это система хранения данных. Для того чтобы ваш хост с операционной системой Windows смог подключиться к хранилищу с интерфейсом iSCSI, достаточно лишь иметь установленный на машине Software Initiator, на данный момент актуальная версия – «Microsoft iSCSI Software Initiator Version 2.01 (build 1748)». В новой версии ОС от Microsoft, Windows Vista, Microsoft iSCSI Software Initiator встроен по умолчанию даже в «домашнюю» версию операционной системы:

И кратко упомянем ещё пару протоколов, которые встречаются более редко и предназначены для предоставления дополнительных сервисов уже существующим сетям хранения данных (SAN):

• FCIP (Fibre Channel over IP) – туннельный протокол, построенный на TCP/IP и предназначенный для соединения географически разнесённых сетей SAN через стандартную среду IP. Например, можно объединить две сети SAN в одну через Интернет. Достигается это использованием FCIP-шлюза, который прозрачен для всех устройств в SAN.

• iFCP (Internet Fibre Channel Protocol) – протокол, позволяющий объединять устройства с интерфейсами FC через IP-сети. Важное отличие от FCIP в том, что возможно объединять именно FC-устройства через IP-сеть, что позволяет для разной пары соединений иметь разный уровень QoS, что невозможно при туннелировании через FCIP.

Какие же параметры характеризуют системы хранения данных? Некоторые из них были перечислены выше – это тип внешних интерфейсов подключения и типы внутренних накопителей (жёстких дисков). Следующий параметр, который есть смысл рассматривать после двух вышеперечисленных при выборе дисковой системы хранения, – её надёжность. Надёжность можно оценить не по банальному времени наработки на отказ каких-то отдельных компонент (факт, что это время примерно равно у всех производителей), а по внутренней архитектуре. «Обычная» система хранения часто «внешне» представляет собой дисковую полку (для монтажа в 19-дюймовый шкаф) с жёсткими дисками, внешними интерфейсами для подключения хостов, несколькими блоками питания. Внутри обычно установлено всё то, что обеспечивает работу системы хранения – процессорные блоки, контроллеры дисков, портов ввода-вывода, кэш-память и так далее. Обычно управление стойкой осуществляется из командной строки или по web-интерфейсу через любой браузер, начальная конфигурация часто требует подключения по последовательному интерфейсу. Пользователь может «разбить» имеющиеся в системе диски на группы и объединить их в RAID (различных уровней), получившееся дисковое пространство разделяется на один или несколько логических блоков (LUN), к которым и имеют доступ хосты (серверы) и «видят» их как локальные жёсткие диски. Количество RAID-групп, LUN-ов, логика работы кэша, доступность LUN-ов конкретным серверам и всё остальное настраивается администратором системы. Обычно СХД предназначены для подключения к ним не одного, а нескольких (вплоть до сотен, в теории) серверов – посему такая система должна обладать высокой производительностью, гибкой системой управления и мониторинга, продуманными средствами защиты данных. Защита данных обеспечивается многими способами, самый простой из которых вы уже знаете – объединение дисков в RAID. Однако данные должны быть ещё и постоянно доступны – ведь остановка одной системы хранения данных, центральной на предприятии, способна нанести ощутимые убытки. Чем больше систем хранит данные на СХД, тем более надёжный доступ к системе должен быть обеспечен – потому что при аварии СХД останавливается работа сразу всех серверов, хранящих там данные. Высокая доступность стойки обеспечивается полным внутренним дублированием всех компонент системы – путей доступа к стойке (портов FibreChannel), процессорных модулей, кэш-памяти, блоков питания и т.д.

Касательно аппаратной части – дисковые стойки могут иметь различные интерфейсы для подключения хостов, различные интерфейсы жёстких дисков, различные схемы подключения дополнительных полок, служащих для увеличения числа дисков в системе, а также другие чисто «железные параметры». Попытаемся понять, какие же параметры характерны для самых ходовых СХД, которые производитель относит к разряду midrange, на примере системы хранения данных EMC Clariion CX500/CX500i. Отличие моделей с буквой «i» и без неё – в реализации внешних интерфейсов: FibreChannel и iSCSI, соответственно.

Обзор внешних дисковых систем хранения данных ведущих производителей.

Внешние дисковые системы хранения данных – в основном это DAS или SAN-системы, а так же NAS.

Корпорация ЕМС предлагает две линейки систем хранения данных SAN – системы высшего уровня Symmetrix и системы среднего уровня CLARiiON. Модель DMX-3 линейки EMC Symmetrix на данный момент является самой мощной и масштабируемой системой хранения данных в мире – сконфигурированная система поддерживает более 1920 жёстких дисков, а сертифицированная ёмкость достигает 1 PB (1 петабайт = 1024 терабайт) данных.

Структурная схема EMC Symmetrix DMX-3

Кроме аппаратных решений, у компании ЕМС существует множество программных продуктов для управления как самими системами хранения, так и сетями хранения данных, а также ПО для защиты данных, перемещения данных между различными системами и прочее. Компания ЕМС является седьмой в мире компанией по выпуску программного обеспечения. Также системы хранения данных EMC поставляют под своей торговой маркой несколько известных сторонних компаний – Dell, Fujitsu-Siemens, Bull.

Следующая компания, которую мне бы хотелось упомянуть, – это HDS (Hitachi Data Systems), являющаяся подразделением компании Hitachi и занимающаяся разработкой и продажами систем хранения данных. Системы среднего уровня представлены оборудованием HDS Thunder 9500V (9530, 9570, 9585, 9520). Системы старшего уровня можно разделить на две линейки (хотя некоторые компании, поставляющие продукцию HDS, объединяют их в одну): Lightning 9900 V Series (модели 9970 и 9980) и TagmaStore Universal Storage Platform (модели HDS USP 100, 600 и 1100). Также у HDS существуют продукты NAS и специализированное программное обеспечение. Сразу в продолжение хочется упомянуть две компании, которые поставляют под своей торговой маркой оборудование HDS – это Sun Microsystems (SUN) и Hewlett-Packard (HP). Системы хранения данных компании SUN также можно раз-делить на три линейки – младшая линейка состоит из OEM-систем компании DotHill, старшая же – из OEM-систем компании HDS. Системы хранения данных среднего уровня можно разделить ещё на две линейки: продукты, самостоятельно разработанные компанией SUN, – это системы SUN StorEdge 6120, 6320, 6920 и OEM-системы от компании Engenio (Sun StorEdge 6130). Получилось немного запутанно, но так уж один из столпов серверостроения выстраивает свой модельный ряд. К слову упомяну, что компания SUN выпускает также свою операционную систему SUN Solaris (под несколько платформ) и всем известный продукт Java. Теперь перейдём ко второму месту чарта продаж – к Hewlett-Packard. Системы хранения данных компании HP можно условно разделить на три группы: системы начального уровня HP MSA (MSA1000, 1500 и другие), системы среднего уровня HP StorageWorks Enterprise Virtual Array (HP EVA 3000, 4000, 6000, 8000) и системы старшего звена, являющиеся OEM-продуктами компании HDS и поставляемые под маркой HP XP (модели XP1000 и XP12000).

HP MSA1000, адаптеры FibreChannel, кабели LC-LC

Конечно, мы не можем обойти вниманием и IBM – одну из мощнейших компаний в отрасли, которая, к слову, год от года попадает в мировые лидеры по количеству полученных патентов на свои изобретения в различных областях высоких технологий. Итак, старшие модели систем хранения от IBM являются разработкой самой компании IBM – это линейки Total Storage серий DS6000 и DS8000. Уровень entry-level и midrange – это OEM-продукция компаний Adaptec и Engenio, сюда входят IBM Total Storage DS300/DS400, DS4100, DS4300, DS4500 и DS4800.

IBM Total Storage серии DS8000

Естественно, аппаратная мощь систем хранения должна как-то управляться, а сами СХД просто обязаны предоставлять уровень сервиса и функциональность, недоступную в обычных схемах «сервер-клиент». Самое первое, что мы уже рассмотрели, – это возможность подключать к СХД несколько хостов (вплоть до сотен, в теории). Второе – система хранения, обычно она обеспечивает 100%-ное дублирование всех своих компонент – нет элементов, выход из строя которых способен вызвать аварийную остановку системы хранения. Также дублированы каналы доступа (пути доступа) к стойке от сервера – в сервер устанавливается несколько HBA (так называемый режим «multipathing»), который позволяют решить сразу несколько проблем:

• Обеспечивается резервирование путей доступа (failover) – при аварийной ситуации с од-ним каналом (повреждение кабеля, поломка адаптера HBA) все данные благополучно транслируются по второму пути.

• Балансировка нагрузки (load balancing) – несколько каналов используются, как один общий, увеличивая пропускную способность и одновременно распределяя нагрузку равно-мерно по всем путям.

Кратко хочется упомянуть о средствах коммутации в среде FibreChannel – о коммутаторах (switches). Основные игроки на этом рынке Cisco, McData, Brocade, QLogic. Практически все коммутаторы, поставляемые крупнейшими производителями СХД под своей торговой маркой – это OEM от Cisco, McData или Brocade.

Коммутаторы Cisco для SAN

Коммутаторы, обладающие большим числом портов, внутренним резервированием управляющих модулей и шин, часто называют «директор» (director). Обычно надёжность директоров составляет т.н. «пять девяток» – 99,999%, они предназначены для работы в качестве ядра (core) сетевой инфраструктуры FibreChannel (или FICON, к примеру) и зачастую строятся по модульному принципу, позволяя создавать нужные конфигурации портов с требуемыми возможностями. К примеру, это может быть большое количество неблокируемых портов, когда все порты могут одновременно функционировать на полной заявленной скорости – в данный момент это 2 Gb и полным ходом идем переход на 4 Gb, таких устройств уже немало. Скорости выше, вплоть до 10 Gb, используются обычно для организации связей между самими коммутаторами (ISL). Коммутаторы для сетей SAN обладают широкими возможностями, позволяя выстраивать подключение устройств по разным схемам, без изменения физической топологии. Управление осуществляется, как и у СХД – web-интерфейс, командная строка, также широки возможности оповещения о критических событиях. Некоторые устройства позволяют обновлять внутреннее программное обеспечение (firmware) без остановки работы. Одна из основных функций коммутаторов – организация зонного разделения устройств SAN, так называемый zoning (зонирование). Зонирование позволяет создавать зоны, которые ограничивают возможность взаимодействия FC-устройств в SAN – ведь абсолютно не нужно (за редким исключением), чтобы два сервера сети «видели» друг друга – это некорректно с точки зрения безопасности и излишне нагружает сеть.

После знакомства с самими системами хранения данных, принципами их построения, предоставляемыми ими возможностями и протоколами функционирования самое время попробовать объединить полученные знания в работающую схему. Попробуем рассмотреть типы систем хранения и топологии их подключения в единую работающую инфраструктуру.

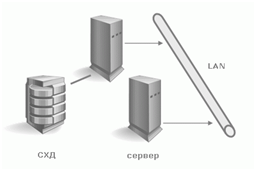

Устройства DAS (Direct Attached Storage) – системы хранения, подключаемые на-прямую к серверу. Сюда относятся как самые простые SCSI-системы, подключаемые к SCSI/RAID-контроллеру сервера, так и устройства FibreChannel, подключенные прямо к сер-веру, хотя и предназначены они для сетей SAN. В этом случае топология DAS является вы-рожденной SAN (сетью хранения данных):

В этой схеме один из серверов имеет доступ к данным, хранящимся на СХД. Клиенты полу-чают доступ к данным, обращаясь к этому серверу через сеть. То есть сервер имеет блочный доступ к данным на СХД, а уже клиенты пользуются файловым доступом – эта концепция очень важна для понимания. Минусы такой топологии очевидны:

• Низкая надежность – при проблемах сети или аварии сервера данные становятся недоступны всем сразу.

• Высокая латентность, обусловленная обработкой всех запросов одним сервером и использующимся транспортом (чаще всего – IP).

• Высокая загрузка сети, часто определяющая пределы масштабируемости путём добавления клиентов.

• Плохая управляемость – вся ёмкость доступна одному серверу, что снижает гибкость распределения данных.

• Низкая утилизация ресурсов – трудно предсказать требуемые объёмы данных, у одних устройств DAS в организации может быть избыток ёмкости (дисков), у других её может не хватать – перераспределение часто невозможно или трудоёмко.

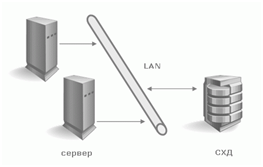

Устройства NAS (Network Attached Storage) – устройства хранения, подключённые напрямую в сеть. В отличие от других систем NAS обеспечивает файловый доступ к данным и никак иначе. NAS-устройства представляют из себя комбинацию системы хранения данных и сервера, к которому она подключена. В простейшем варианте обычный сетевой сервер, предоставляющий файловые ресурсы, является устройством NAS:

Все минусы такой схемы аналогичны DAS-топологии, за некоторым исключением. Из добавившихся минусов отметим возросшую, и часто значительно, стоимость – правда, стоимость пропорциональна функциональности, а тут уже часто «есть за что платить».

NAS-устройства могут быть простейшими «коробочками» с одним портом ethernet и двумя жёсткими дисками в RAID1, позволяющими доступ к файлам по лишь одному протоколу CIFS (Common Internet File System) до огромных систем в которых могут быть установлены сотни жёстких дисков, а файловый доступ обеспечивается десятком специализированных серверов внутри NAS-системы. Число внешних Ethernet-портов может достигать многих десятков, а ёмкость хранимых данных – несколько сотен терабайт (например EMC Celerra CNS). Такие модели по надёжности и производительности могут далеко обходить многие midrange-устройства SAN. Что интересно, NAS-устройства могут быть частью SAN-сети и не иметь собственных накопителей, а лишь предоставлять файловый доступ к данным, находящимся на блочных устройствах хранения. В таком случае NAS берёт на себя функцию мощного специализированного сервера, а SAN – устройства хранения данных, то есть мы получаем топологию DAS, скомпонованную из NAS- и SAN-компонентов.

NAS-устройства очень хороши в гетерогенной среде, где необходим быстрый файловый доступ к данным для многих клиентов одновременно. Также обеспечивается отличная надёжность хранения и гибкость управления системой вкупе с простотой обслуживания. На надёжности особо останавливаться не будем – этот аспект СХД рассмотрен выше. Что касается гетерогенной среды, доступ к файлам в рамках единой NAS-системы может быть получен по протоколам TCP/IP, CIFS, NFS, FTP, TFTP и другим, включая возможность работы NAS, как iSCSI-target, что обеспечивает функционирование с различным ОС, установленными на хостах. Что касается лёгкости обслуживания и гибкости управления, то эти возможности обеспечиваются специализированной ОС, которую трудно вывести из строя и не нужно обслуживать, а также простотой разграничения прав доступа к файлам. К примеру, возможна работа в среде Windows Active Directory с поддержкой требуемой функциональности – это может быть LDAP, Kerberos Authentication, Dynamic DNS, ACLs, назначение квот (quotas), Group Policy Objects и SID-истории. Так как доступ обеспечивается к файлам, а их имена могут содержать символы различных языков, многие NAS обеспечивают поддержку кодировок UTF-8, Unicode. К выбору NAS стоит подходить даже тщательнее, чем к DAS-устройствам, ведь такое оборудование может не поддерживать необходимые вам сервисы, например, Encrypting File Systems (EFS) от Microsoft и IPSec. К слову можно заметить, что NAS распространены намного меньше, чем устройства SAN, но процент таких систем всё же постоянно, хотя и медленно, растёт – в основном за счёт вытеснения DAS.

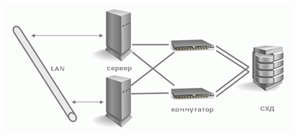

Устройства для подключения в SAN (Storage Area Network) – устройства для подключения в сеть хранения данных. Сеть хранения данных (SAN) не стОит путать с локальной сетью – это различные сети. Чаще всего SAN основывается на стеке протоколов FibreChannel и в простейшем случае состоит из СХД, коммутаторов и серверов, объединённых оптическими каналами связи. На рисунке мы видим высоконадёжную инфраструктуру, в которой серверы включены одновременно в локальную сеть (слева) и в сеть хранения данных (справа):

После довольно детального рассмотрения устройств и принципов их функционирования нам будет довольно легко понять топологию SAN. На рисунке мы видим единую для всей инфраструктуры СХД, к которой подключены два сервера. Серверы имеют резервированные пути доступа – в каждом установлено по два HBA (или один двухпортовый, что снижает отказоустойчивость). Устройство хранения имеет 4 порта, которыми оно подключено в 2 коммутатора. Предполагая, что внутри имеется два резервируемых процессорных модуля, легко догадаться, что лучшая схема подключения – когда каждый коммутатор подключён и в первый, и во второй процессорный модуль. Такая схема обеспечивает доступ к любым данным, находящимся на СХД, при выходе из строя любого процессорного модуля, коммутатора или пути доступа. Надёжность СХД нами уже изучена, два коммутатора и две фабрики ещё более увеличивают доступность топологии, так что если из-за сбоя или ошибки администратора один из коммутационных блоков вдруг отказал, второй будет функционировать нормально, ведь эти два устройства не связаны между собой.

Показанное подключение серверов называется подключением с высокой доступностью (high availability), хотя в сервере при необходимости может быть установлено ещё большее число HBA. Физически каждый сервер имеет только два подключения в SAN, однако логи-чески система хранения доступна через четыре пути – каждая HBA предоставляет доступ к двум точкам подключения на СХД, к каждому процессорному модулю раздельно (эту возможность обеспечивает двойное подключение коммутатора к СХД). На данной схеме самое ненадежной устройство – это сервер. Два коммутатора обеспечивают надежность порядка 99,99%, а вот сервер может отказать по разным причинам. Если необходима высоконадёжная работа всей системы, серверы объединяются в кластер, приведённая схема не требует никакого аппаратного дополнения для организации такой работы и считается эталонной схемой организации SAN. Простейший же случай – серверы, подключённые единственным путем через один свитч к системе хранения. Однако система хранения при наличии двух процессорных модулей должна подключаться в коммутатор как минимум одним каналом на каждый модуль – остальные порты могут быть использованы для прямого подключения серверов к СХД, что иногда необходимо. И не стоит забывать, что SAN возможно построить не только на базе FibreChannel, но и на базе протокола iSCSI – при этом можно использовать только стандартные ethernet-устройства для коммутации, что удешевляет систему, но имеет ряд дополнительных минусов (оговоренных в разделе, рассматривающем iSCSI). Также интересна возможность загрузки серверов с системы хранения – не обязательно даже наличие внутренних жёстких дисков в сервере. Таким образом, с серверов окончательно снимается задача хранения каких-либо данных. В теории специализированный сервер может быть превращён в обычную числодробилку без каких-либо накопителей, определяющими блоками которого являются центральные процессоры, память, а так же интерфейсы взаимодействия с внешним миром, например порты Ethernet и FibreChannel. Какое-то подобие таких устройств являют собой современные blade-серверы.

Хочется отметить, что устройства, которые возможно подключить в SAN, не ограничены только дисковыми СХД – это могут быть дисковые библиотеки, ленточные библиотеки (стримеры), устройства для хранения данных на оптических дисках (CD/DVD и прочие) и многие другие.

Из минусов SAN отметим лишь высокую стоимость её компонент, однако плюсы неоспоримы:

• Высокая надёжность доступа к данным, находящимся на внешних системах хранения. Независимость топологии SAN от используемых СХД и серверов.

• Централизованное хранение данных (надёжность, безопасность).

• Удобное централизованное управление коммутацией и данными.

• Перенос интенсивного трафика ввода-вывода в отдельную сеть, разгружая LAN.

• Высокое быстродействие и низкая латентность.

• Масштабируемость и гибкость логической структуры SAN

• Географически размеры SAN, в отличие от классических DAS, практически не ограничены.

• Возможность оперативно распределять ресурсы между серверами.

• Возможность строить отказоустойчивые кластерные решения без дополнительных затрат на базе имеющейся SAN.

• Простая схема резервного копирования – все данные находятся в одном месте.

• Наличие дополнительных возможностей и сервисов (снапшоты, удаленная репликация).

• Высокая степень безопасности SAN.